生成性人工智能的应用与安全风险

关键要点

生成性人工智能GenAI的创新和发展在过去18个月中取得了颠覆性进展。预测到2026年,超过80的企业将部署GenAI应用程序,但安全风险严重。企业在开发和部署GenAI应用时需有效平衡创新与安全之间的关系。组织需要实施数据治理与安全控制,以防止敏感数据泄露。生成性人工智能GenAI在过去18个月的创新与发展没有任何对手。根据Gartner的预测,到2026年,超过80的企业将会在生产环境中部署GenAI应用程序或使用GenAI应用编程接口API或模型,而这一比例在2023年还不到5。然而,GenAI应用的开发和部署面临着很大的安全风险,而安全措施并未跟上创新的步伐。根据IBM商业价值研究所的一项最新调查,82的受访者认为安全可信的人工智能对业务成功至关重要,但69的受访者表示,创新仍然优先于安全。

那么,组织如何能够在不妥协安全的前提下,充分利用GenAI应用的开发与部署呢?

开发GenAI应用的风险与机遇

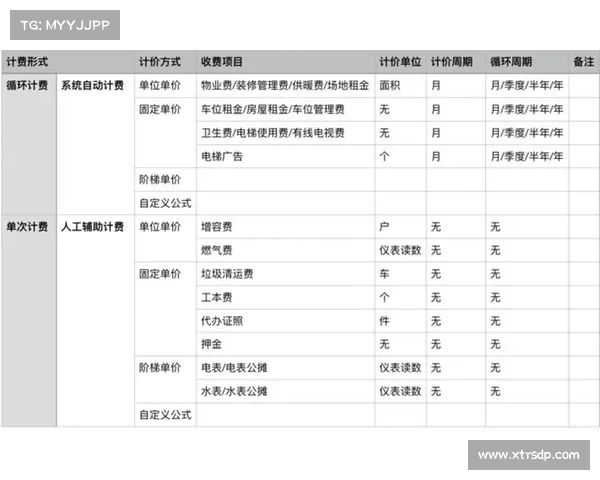

组织可以通过利用专有数据定制AI模型来最大化价值;直接使用现成的通用模型几乎无法提供额外价值。Gartner预测到2027年,超过50的企业GenAI模型将专门针对某个行业或业务职能,这一比例相比2023年的约1有了显著增长。

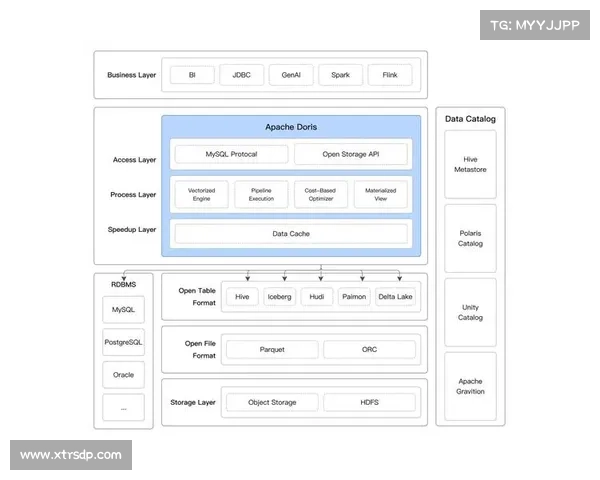

许多组织在其GenAI应用中使用检索增强生成RAG架构,该架构将组织的专有数据提供给大型语言模型LLM,帮助训练这些模型,以及创建提示以便LLM生成准确的、所需的输出。这种方法使团队能够开发与其组织及独特需求相适应的应用程序。

然而,这也带来了保密数据流出组织,甚至被用于训练其他模型的风险。专有数据以提示的形式输入LLM,这可能会成为攻击的目标。

在使用这些模型时,敏感或机密数据泄露的风险一直是人们关注的焦点,但我们并不必对此熟视无睹。在数据的进出层面设置治理与安全控制,将有助于应对主要的安全问题。我们需要对来自互联网和外部来源的数据及流量进行细粒度的控制,同时规范从GenAI应用流出的流量。主要的考量是确保特定数据不会以无法监管的方式离开企业。

开发人员和安全团队之间的紧张关系

希望开发和部署GenAI应用的组织必须赋予开发人员权力,允许他们自由实验。然而,被指派避免和减轻安全风险的平台工程师和安全团队希望设定尽可能多的控制措施,这在这两个同样重要的群体之间产生了紧张关系。

我们必须在GenAI开发和部署的每一个层面上设置安全措施,以避免可能灾难性的后果。如今,团队在设置治理和安全护栏方面面临重大挑战。平台和/或安全工程师必须在GenAI应用层面上设置细粒度的控制,以规范进入和离开的数据流。在没有护栏的情况下,赋予开发人员安全实验和创新的能力几乎是不可能的。

为了促进相互受益的关系,安全领导者应当将开发人员纳入他们的安全工作中,让他们参与制定自己的安全控制,并提供合适的工具来实现他们的目标。

开源在其中的角色

开源带来了更多的机会和风险。假设组织有多个GenAI应用程序,每个应用程序又由多个服务组成,它们很可能在应用程序中使用了大量的开源组件,以及一些现成的开源模型。

蚂蚁NPV加速器虽然用户可以直接使用现成的模型,但这些模型存在风险,因为无法保证这些模型没有被攻破。强制实施一定程度的多租户,或者在应用程序之间保持隔离的原则是至关重要的。这样一来,如果某个应用程序被攻破,边界能够确保其他应用程序不受影响。能够在应用程序层面,甚至在命名空间层面实施这些控制和隔离措施,成为了一种“必备功能”。这些安全护栏是预防措施,用以确保一旦发生安全事件,用户能够在有限的影响范围内控制事态。

尽管围绕GenAI存在